La ONU acoge una reunión de expertos para debatir la prohibición de las llamadas armas autónomas, aquellas programadas para no depender de la decisión del hombre

«No hay mucho tiempo para actuar. Una vez que se abra la caja de Pandora, será difícil volver a cerrarla», alertan científicos e investigadores de todo el mundo

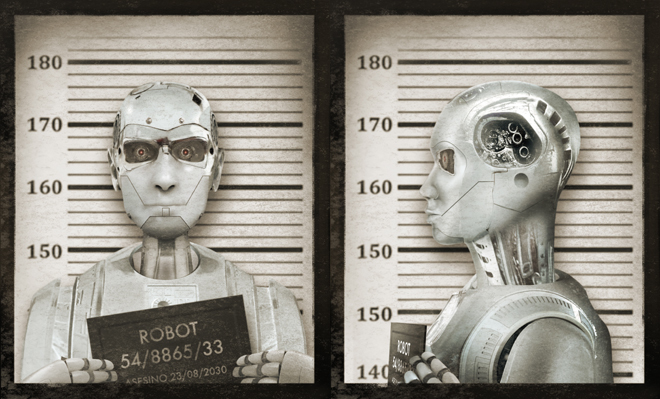

¿Hay que prohibir los robots asesinos?

«Imaginemos un tranvía camino de una intersección», plantea el científico. «En el cruce hay un hombre que puede controlar el cambio de vías. En una de ellas hay una persona atada en el carril, como en las viejas películas de cine mudo, y morirá si el tranvía avanza en su dirección. No habrá problema si el hombre que controla el cambio de agujas desvía la ruta. Pero… ¿qué pasa si en la otra vía no hay una, sino dos personas atadas? ¿Qué haría entonces el ser humano? ¿Y si una de las personas es pariente suyo? ¿Y si en la otra vía hay una mujer embarazada? Fíjese en la cantidad de variantes que puede valorar el hombre… ¿Podría valorarlas el tranvía por sí solo?».

El dilema, un experimento clásico del pensamiento ético, lo recupera ahora Guillermo Simari, doctor en Ciencias por la Universidad de Washington y Catedrático de Inteligencia Artificial y Lógica computacional en la Universidad Nacional del Sur de Bahía Blanca (Argentina). En el año 2015 organizó en Buenos Aires la Conferencia Internacional de Inteligencia Artificial, el congreso más importante sobre la materia. Allí se presentó una primera carta firmada por más de 1.000 científicos, técnicos y pensadores, entre ellos Elon Musk, Stephen Hawking o Noam Chomsky, en la que se alertaba de la amenaza de una «tercera revolución bélica». Después de la pólvora y las armas nucleares, llegan los robots asesinos. Las «armas autónomas», en terminología técnica.

Cambien el tranvía por un dron, un soldado ciborg o un terminator y, al señor amarrado a las vías del tren por cualquier eventual víctima en un conflicto. ¿Quién decide?

«Para evitar un futuro en el que los robots asesinos, y no los humanos, tomen las decisiones, los gobiernos deben actuar ahora», asegura Mary Wareham, miembro de la ONG Human Rights Watch y coordinadora de la Campaña ‘Stop Killer Robots’, que lleva desde 2013 peleando para trasladar la reclamación de los expertos hasta las Naciones Unidas. Esta semana lo ha conseguido. Hoy finaliza en Ginebra la segunda cumbre del grupo de expertos gubernamentales sobre armas convencionales en la que representantes de más de 80 países debaten un nuevo tratado internacional que prohíba el desarrollo, la producción y el uso de armamento totalmente autónomo antes de 2020.

El pasado lunes se discutió la definición de este tipo de munición y las implicaciones del término «letal» y el miércoles, la necesidad de mantener el control humano sobre los robots.

EEUU, Rusia, China e Israel defienden la tecnología. Francia y Alemania han cambiado su postura en las últimas semanas para promover medidas que no pasen necesariamente por la restricción total. Y España se ha limitado a respaldar la existencia de la comisión.

«Los países más comprometidos (sólo 22 apoyan inequívocamente la prohibición) son los que no tienen la tecnología para desarrollar este tipo de armas, por ejemplo los países latinoamericanos o los africanos, porque ven que las potencias más grandes podrían poner a prueba este armamento en conflictos como los que se llevan a cabo en este momento en Oriente Medio o en África», alerta Camilo Serna, portavoz de la campaña. «Nuestra mayor preocupación es que las armas autónomas se desplieguen antes de que exista una regulación y comiencen a causar víctimas».

LAS ARMAS AUTÓNOMAS SON ARMAS DE DESTRUCCIÓN MASIVA CON UNA CAPACIDAD ILIMITADA. ECHAREMOS DE MENOS LOS ‘BUENOS VIEJOS TIEMPOS’ DE LAS ARMAS QUÍMICAS

El CBU-97 Sensor Fuzed Weapon es una bomba de racimo del ejército americano. Según los expertos, la más avanzada del mundo. Un arma guiada de precisión equipada con electrónica inteligente para localizar y alcanzar objetivos y programada para reconocer y bloquear ella sola el hardware militar enemigo y destruirlo.

El Sea Hunter es un cazador estadounidense de submarinos que avanza sin tripulación, Taranis es el nombre de un dron británico que puede realizar tareas de vigilancia y espionaje, marcar objetivos, transportar armas, realizar fotografías aéreas y atacar en territorio hostil. Todo sin un piloto en su interior. Harpy es un arma autónoma desarrollada por la industria aeroespacial israelí que «dispara y olvida». La arpía detecta, ataca y destruye sin ayuda de nadie los emisores de radar enemigos.

Y así hasta 381 sistemas distintos de armamento autónomo ha contabilizado en todo el mundo el Instituto Internacional para la Investigación de la Paz de Estocolmo (Sipri) en su último informe. La mayor parte de ellos son propiedad de Israel, Rusia o EEUU.

Jean-Charles Ledé es uno de los máximos responsables de la Agencia americana de Proyectos de Investigación Avanzados de Defensa, creada tras la Guerra Fría. En 2015 aseguró que el objetivo de su programa de drones era poder «cazar en manada, como los lobos». Sólo en su primer año en la Casa Blanca, Barack Obama autorizó más ataques de drones (54) que George Bush en sus últimos cuatro años de mandato. Entre 2009 y 2011 las víctimas de los aviones americanos no tripulados oscilaron entre las 1.324 y las 2.348, según los datos de la New American Foundation.

«Uno puede desear que no se haga, igual que uno desearía que no existiesen las armas atómicas, pero si no se ha podido controlar el uso de uranio, cómo vas a controlar el de software. El genio salió de la botella y es muy difícil que vuelva a entrar«, lamenta el doctor Simari.

Coinciden todos los expertos en que construir un arma autónoma es mucho más fácil que construir un coche sin conductor. «Sin embargo, las armas autónomas son armas de destrucción masiva con una capacidad ilimitada de crecer a escala», denuncia Stuart Russell, profesor de Ciencias de la Computación en la Universidad de California en Berkeley y uno de los firmantes de una nueva carta remitida a la ONU en 2017. «Las armas autónomas letales permitirán que el conflicto armado se dispute a una escala mayor que nunca, y en periodos de tiempo más rápidos de lo que los humanos pueden comprender. Pueden ser armas de terror, armas que los déspotas y terroristas usen contra poblaciones inocentes, y armas pirateadas para comportarse de maneras no deseadas. No tenemos mucho tiempo para actuar», alerta el texto. «Una vez que se abra la caja de Pandora, será difícil cerrarla».

TODO LO QUE POSIBILITA QUE LOS COCHES SEAN AUTÓNOMOS SIRVE TAMBIÉN PARA HACER ARMAS AUTÓNOMAS. UNO PUEDE UTILIZAR UN CUCHILLO PARA CORTAR PAN O PARA MATAR

La semana pasada, Russell y otro medio centenar de expertos en Inteligencia Artificial anunciaron también su decisión de boicotear cualquier actividad académica relacionada con el Instituto Avanzado de Ciencia y Tecnología (KAIST), una de las más prestigiosas universidades estatales surcoreanas, por su proyecto para desarrollar armas autónomas que podrían convertirse en «instrumentos del terror».

«Es fácil entender que un arma autónoma no necesita de un supervisor, por lo que puede disparar tanto como quiera, de la misma forma que Google responde más de un billón de consultas al año, mediante el despliegue de millones de computadoras que funcionan de forma autónoma en paralelo», explica Russell.

Su visión no es compartida por toda la comunidad científica. Hay expertos que consideran que no se puede frenar el desarrollo de la inteligencia artificial y que siempre podrá ser controlada por los humanos. Ricardo Rodríguez, investigador de laUniversidad de Buenos Aires, es uno de los que rechaza el alarmismo. «Parece que estamos cerca del Apocalipsis con la robótica, pero lo cierto es que estamos lejos de hacer robots bélicos asesinos. Hace 20 años se hablaba del peligro de la clonación y fíjese cómo estamos ahora», aseguraba en la conferencia de 2015.

Los gobiernos partidarios del armamento autónomo defienden igualmente que, en último término, es mejor enfrentar a robots que a seres humanos. Stuart Russell lo rebate. «Supongamos que los robots españoles hubieran vencido a los robots ingleses en 1588. ¿Creen que Inglaterra se hubiera rendido y aceptado una monarquía católica española en Londres?», se pregunta el profesor de Berkeley. «También podrían argumentar que las guerras se pueden resolver jugando al fútbol o con una partida de parchís… Una vez que los robots de un país sean derrotados, los robots del enemigo procederán a atacar a soldados y civiles humanos, hasta que se destruya toda la resistencia».

Más allá del plano científico, la tecnología plantea un debate jurídico, discutido también este miércoles en la ONU. Los profesores de Derecho Internacional Cesáreo Gutiérrez Espada y María José Cervell presentaron un estudio en 2013 sobre las consecuencias legales del uso de armas autónomas y concluyeron que no existe seguridad alguna de la capacidad de un robot autónomo para cumplir principios básicos del Derecho Internacional y de los derechos humanos, «en particular los principios de distinción, discriminación o proporcionalidad«.

Y además, como sostienen desde ‘Stop Killer Robots’, «no hay tribunales para juzgar a una máquina».

PARA EVITAR UN FUTURO EN EL QUE LOS ROBOTS ASESINOS, Y NO LOS HUMANOS, TOMEN LAS DECISIONES, LOS GOBIERNOS DEBEN ACTUAR AHORA. NO TENEMOS MUCHO TIEMPO

Para Guillermo Simari el único freno posible puede llegar desde la ética. «No soy optimista con respecto al control, pero sí respecto al desarrollo de sistemas que tengan embebidos ciertos componentes de ética en el uso. Porque ya hay armas que deciden disparar o bombardear prácticamente solas, la tecnología ya lo permite. Todo lo que posibilita que los coches sean autónomos sirve también para hacer armas autónomas. No se puede desarrollar algo sólo para el bien. Uno puede utilizar un cuchillo para cortar pan o para matar a alguien. Todas las aplicaciones son para el bien y para el mal. Pasó con la química o la genética, hasta con Facebook. Todo lo que hacemos en Ciencia tiene al menos un par de aplicaciones y el freno debe venir desde la moral, desde nuestra educación».

¿Hay optimismo entre los científicos respecto a las resoluciones de la ONU? Responde Stuart Russell: «Creo que hay menos de un 50% de posibilidades de que las negociaciones de la ONU en Ginebra consigan un acuerdo lo suficientemente rápido como para evitar que el armamento autónomo se fabrique y se despliegue ampliamente. Y una vez que esto suceda, será muy difícil retroceder».

– ¿Veremos en un futuro cercano guerras entre robots como en las películas de ciencia ficción?

– Es mucho más probable que pronto veamos a robots cazando y matando humanos. Y entonces echaremos de menos los «buenos viejos tiempos» de las armas químicas…

Sólo 22 países respaldan la prohibición total

Hasta el mes pasado, 22 estados habían dado su apoyo a la iniciativa para prohibir las armas completamente autónomas, entre ellos Argentina, Brasil, Irak, Venezuela, Palestina, Zimbabue o la Santa Sede. Según la campaña ‘Stop Killer Robots’, los ejércitos de EEUU, China, Israel, Corea del Sur, Rusia y Reino Unido ya usan o están desarrollando sistemas de armas autónomas «con niveles decrecientes de control humano». El escrito presentado esta semana por el gobierno americano en Ginebra defiende que los sistemas autónomos reducen las bajas civiles y llega a asegurar que las armas «no son inherentemente ofensivas». Entre el 27 y el 31 de agosto de este año la ONU celebrará una tercera reunión del grupo de expertos sobre la materia.